机器学习作为人工智能技术的重要分支,已经广泛应用在包含金融风控等多个场景中,成为大数据与人工智能时代的“基础能力”。而随着机器学习发展和应用的深入,模型“可解释性”的问题也越来越被公众关注。2021年出台的《个人信息保护法》,要求自动化决策应当保证决策的透明度和结果公平、公正,不得在交易条件上实行不合理的差别待遇;通过自动化决策方式作出对个人权益有重大影响的决定,个人有权要求个人信息处理者予以说明。本文基于对常见机器学习模型的介绍,以国内外真实案例为基础,尝试探讨金融风控场景模型可解释性问题的成因及对策,并给出了一些解释风险认定的准则。

一、机器学习模型的信任危机

我们是如何区分哈士奇和狼的?我们人类可以通过经验来区分温顺的家犬和危险的野生动物。但是机器学习算法根据模型分类器的数据和权重,这个结果的判断是如何做出的则是个谜。

2016年,加州大学欧文分校的研究表明,区分哈士奇犬和狼的高度准确的算法并不是通过区别动物本身的样貌属性,而是根据辅助数据做出决策的——特别是雪的存在。这一测试结果引出了一个重要的问题:如果我们无法解释机器学习算法的黑盒工作原理,我们怎么相信它给出的结果?

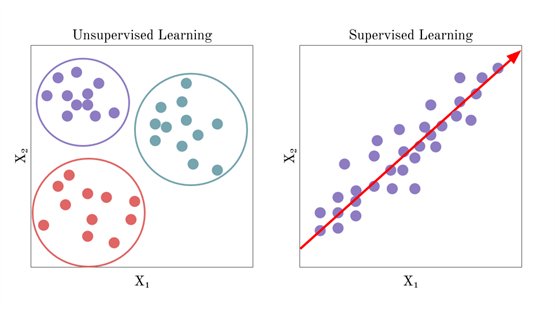

机器学习的种类繁多,但是一般我们会根据训练期间接受的监督数量和监督类型进行分类,将机器学习分为以下两种类型:有监督学习、无监督学习。

在有监督学习中,算法需要解决方案的训练数据来做标签或标记,以此指导算法作出符合训练规律的决策。简单的有监督线性模型中,我们可以通过检查分类器的结构获得线索,从而了解运算逻辑。但随着模型复杂性的增加,机器学习模型变成了“黑盒”,算法越复杂,结果就越难解释。同时,我们也认为数据标签越多,结果也越准确。准确性和可解释性在有监督算法的实际落地中产生了矛盾。

二、为什么金融风控需要可解释性?

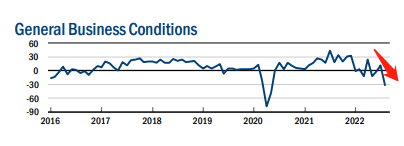

当机器学习的预测结果对用户的隐私和安全产生影响,而机器学习的建模者或用户会因此面临法律或财务风险时,一个具有可解释性和说服力的风控结论就变得至关重要。高盛的Apple Card就曾发生过一起机器学习模型训练结论存在争议的负面事件,一位知名企业家指责高盛存在歧视,因为他的妻子尽管信用评分比他高,但仍被拒绝增加信用额度,高盛的信用卡业务因此受到了审查。这起投诉事件引发了纽约州金融服务部(DFS)进行了一项关于算法的调查,调查信用额度的算法是否存在性别歧视等违法行为。由此可见,可解释性是保护消费者权益的必需品,也是保证金融机构健康、安全、合规运行的重要指标。

三、金融风控的痛点

虽然我们已经了解到可解释性在金融风控中的重要性,但是想要将可解释性的算法落地在金融风控场景并不是一件易事。金融行业的大数据资源丰富,数据应用由来已久,为满足丰富的用户需求和不断提升的用户体验,对金融业务创新模式的要求和对大数据处理能力的要求也水涨船高。

▪

数字化的欺诈风险升级

传统银行在数字化过程中,欺诈攻击也随着银行数字化业务的升级一并进化,个人欺诈攻击向有组织的团伙型欺诈攻击转变,规模更大,技术更加专业,所造成的欺诈损失也更多。

▪

风控体系需要智能化与专家决策的有机结合

随着数据的不断积累,运营客户的案例和数据的维度都更加丰富,在这种背景下传统的专家决策模式在效率和精度上都存在问题,所以需要以智能方案为核心、依据量化结论形成决策、并结合专家运营输出可解释的风控意见。

▪

风控决策时间要求极短

原有的金融风控体系响应时间长,难以做到实时检测。当前更多的业务正在往线上转移,留给技术后台的处理时间可能只有一秒钟,这就对大数据处理的技术架构提出了极高的要求。而产生客诉后,留给风控业务的审核时间也是少之又少。

四、无监督模型在风控领域的工作原理

一个常见的误区是:无监督机器学习(UML)由于其不需要标记数据来发现新模式,更像是一种黑盒模型。

但是,事实相反。

无监督学习模型可以风控领域识别欺诈者时,提供良好的解释性。无监督学习与有监督学习的核心区别是训练数据只有自变量没有因变量(就是没有Y值)。常见的无监督学习有聚类算法、可视化和降维、关联规则学习。

聚类或基于关联分析的无监督学习在风控场景可以得到极佳的应用,因为它能够提供出特殊交易或欺诈活动的具体原因代码,主要是通过聚类出不同维度的特征,如活动、行为、时间和其他因素,结果常常以可疑的分组形式出现。这些特征可以在模型的图表中直观地聚集在一起,这些聚集行为展示了欺诈团伙的可疑活动、联系方式和作案规律。这样我们既可以获得高准确性的欺诈团伙捕捉,又可以解释机器学习的决策理由。

图中展现了无监督机器学习的特点,它将可疑用户和事件聚集,因为从风控经验上讲:“好人分散,坏人扎堆”。为了集中获得高的欺诈收益,欺诈者往往会躲避规则的同时又在规则的极限边缘试探,从而形成了一些正常用户不会出现的行为数据,这在不同聚类子空间中会被定义为可疑团伙。

五、无监督机器学习的风险事件认定

无监督学习依靠其不依赖标签、捕捉特殊群组、具有可解释性的这三大特点,它为何能够在金融风控领域成功落地并解决金融风控中的核心痛点呢?

▪

第一,因为欺诈者为逃避风控规则,其手法变化快,仅依赖历史数据和标签往往难以捕捉新型未知欺诈。

▪

第二,现代欺诈逐渐形成了链条化、组织化的专业形态,巨额欺诈损失的背后是团伙型欺诈者的高效工作。

▪

第三,金融机构追求客户体验,而风控业务人员又不希望规则造成大量客诉,具有可解释性的模型至关重要。

基于这三点,无监督学习的用武之地可见是风控领域。

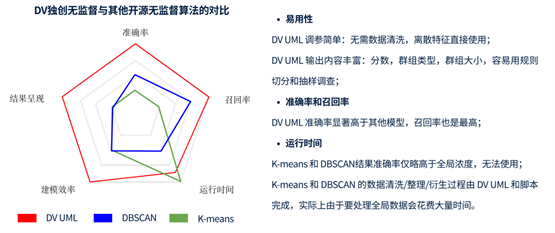

不过,无监督学习在实际落地中的可用性和效果一直存疑,人们常问:靠聚类如何区分是欺诈团伙还是行为良好的团队?其实,仅靠一些开源的无监督算法,比如K-means或DBSCAN,聚类逻辑主要依靠运算距离等方式,这样的预测结果的确是不可用的。想要稳稳落地,一个可用的算法必须结合风控经验来打通逻辑,也就是在聚类子空间中,“聚”出针对风控场景的可疑群组,这既需要经验支持,也有一定技术门槛。

那么,一个可用的无监督学习算法是如何判定风险事件和欺诈用户的?维择科技在服务全球金融机构的案例中,总结了许多可复用的聚类子空间和规则。

案例一:

维择科技依靠无监督学习算法,发现了疑似黑中介代办的欺诈申请团伙,其中涉及18个申请人分别通过虚假信息包装提交贷款申请。欺诈者运用了一定的伪装手法:该群组中申请人的个人信息(名称、证件号、手机号、家庭地址等)均不相同,大多数申请人的单位名称不同。申请时间相对分散在周内的不同时间。在一般规则审查中,很难发现这些看似不相关的人是同一个犯罪团伙。

无监督算法从不同聚类子空间中摘出了这些申请人的可疑共同点:

▪

18个申请账户中12个账户的家庭地址与征信信息中的家庭地址不一致,且11个账户的城市信息不一致;

▪

18个申请均通过手机浏览器完成,其中使用的苹果手机IOS版本较低;

▪

每单申请过程中均出现登陆的GPS不唯一,且存在跨城市的现象;

▪

不同申请之间都有登录同一城市的GPS信息,且登陆的均为苹果手机。

案例二:

维择科技在为某股份制银行卡中心进行信用卡反诈场景的检测服务时,发现了疑似养卡提额的团伙,他们紧扣住银行信用评估系统和风控系统的规则,投入成本并长期保持信用卡活跃,制造出真人刷卡消费的假象。

无监督算法则能够摘出这些持卡人的可疑共同点:

▪

特定借记卡给多个信用卡账户还款,还款金额集中;

▪

每个信用卡账户都在过固定多个商户交易,且为同一家收单机构,收单机构所在地相同;

▪

每个卡的消费总额是授信额度的数倍;

▪

每天1分钟同一个商户消费多笔,且金额类似;

▪

每天还款1笔,且金额集中。

这两个案例中的特征合并在一起看,是高度可疑的,但在逐个筛查中极难被发现。

总而言之,并非所有机器学习模型都是黑盒,对于大多数应用场景来说,一定程度的可解释性足以满足法律和监管的要求。对于金融场景的欺诈检测,从业者则更推崇准确性与可解释性并存的算法。发现不同机器学习的用武之地,向所有人展示“这是狼,不是哈士奇”的理由。

作者:维择科技李梦晓

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

关键词:

首页

首页

营业执照公示信息

营业执照公示信息